Metadaten-Management in Data-Fabric

Im zweiten Blog-Artikel unserer Blog-Serie zu Metadaten haben wir erklärt, warum einst bewährte Strategien für ein modernes Metadaten-Management nicht mehr geeignet sind. Nachdem Gartner das aktive Metadaten-Management als neuen Trend und entscheidendes Konzept moderner verteilter Datenarchitekturen identifiziert hat, haben wir die wichtigsten Bestandteile näher beleuchtet. In diesem dritten und letzten Artikel über Metadaten-Management erklären wir die Prinzipien des Metadaten-Managements in Data-Fabric-Architekturen.

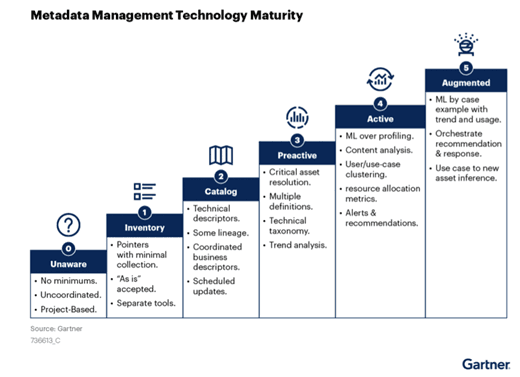

Reifegrad-Modell für Metadaten-Technologien

Laut Gartner entwickeln sich aktive Metadaten-Management-Architekturen in verschiedenen Phasen.

Am Anfang steht ein noch unkoordiniertes Ad-hoc-Metadaten-Management, bei dem noch keine Standards existieren und die Projekte in ihrer Strategie noch unabhängig nebeneinanderstehen. Der nächste Entwicklungsschritt ist die Definition unternehmensweiter Praktiken für Standards, die eigene Tools nutzen und erste Erkenntnisse mit Fokus auf Datenflüsse und Datenabstammungen ermöglichen. Schliesslich wird das Niveau erreicht, auf dem Verfahren des maschinellen Lernens genutzt werden können, um die gewünschte, oben beschriebene aktive Metadaten-Management-Funktionalität bereitzustellen.

Jeder Schritt in diesem Prozess muss sorgfältig und mit einer klaren Vision im Kopf geplant und durchgeführt werden. Es ist gut, in dieser Übergangsphase auf die Erfahrung und das Know-how von Unternehmen wie Mimacom zurückgreifen zu können.

Auf Grundlage der präsentierten Marktforschung sind augmentierte Daten-Management-Funktionen von zentralem Interesse. Dies kann als wesentliche treibende Kraft hinter dem Paradigmenwechsel bei Metadaten-Management-Plattformen angesehen werden. Für Gartner sind passive Metadaten-Managementsysteme keineswegs dem Untergang geweiht – das Unternehmen prognostiziert jedoch, dass autonome Systeme wie solche, die dem aktiven Metadaten-Management zugrunde liegen, künftig erheblich an Dynamik gewinnen werden. Und der Grundbaustein des aktiven Metadaten-Managements wird die KI sein.

Metadaten-Management ist Teil einer Data-Fabric-Architektur

Moderne Architekturen von Datenplattformen stehen zahlreichen Herausforderungen gegenüber. Wie eingangs erwähnt, adressiert eine Data-Lake-Architektur zwar die Anforderung nicht homogener Datenbestände, sie wird jedoch weder den Anforderungen von Multi- oder hybriden Cloud- noch von föderalen Domänen-Lösungen gerecht.

Datenplattform-Architekturen wie Data Mesh oder Data Fabric machen sich die Konzepte des Domain-Driven-Designs (DDD) zu eigen und bevorzugen daher verteilte, unabhängige Datendomänen und adressieren die Anforderung einer Integration verschiedenster Technologien und Tools.

Data-Fabric- und Data-Mesh-Konzepte behandeln all die Probleme, die in modernen, komplexen, nicht-homogenen Datenplattformen entstehen, wählen dabei jedoch leicht unterschiedliche Strategien. Beide Entwicklungen zielen auf die Bereitstellung ganzheitlicher Daten-Insights ab. Während sich jedoch Data Mesh auf die verteilte, domänenzentrierte Datenverwaltung konzentriert, stellt Data Fabric die nahtlose Integration und die gemeinsame Nutzung von Daten in den Mittelpunkt.

Data-Mesh-Architektur betont sehr stark DDD und ist API-getrieben, daher bevorzugt sie Projektunabhängigkeit und verlässt sich auf die Integration auf höherer Ebene. Die Konformität mit der Data Governance wird bei diesem Ansatz getrennt durchgesetzt und die finale Data-Governance-Schicht bildet sich heraus. Das Data-Fabric-Konzept umfasst zwar ebenfalls verteilte und domänengetriebene Architekturen, lässt sich jedoch eher als Low-Code-Lösung beschreiben , die durch KI-Augmentation getrieben wird.

Sichtbarer werden die Unterschiede beim Thema Metadaten-Management. Die Data Governance, von der Metadaten-Management einen Teil bildet, zeigt bei Data-Mesh-Architekturen eine Bottom-up-Struktur. Sie stützt sich auf die Verantwortlichkeit der einzelnen Domänen, bleibt föderal und die Integration erfolgt unter Nutzung zentraler Regelungen. In einer Data-Fabric-Architektur, die sich ja von Beginn an auf das Daten-Management und die Sicherheit konzentriert, sollte Governance eine integrierte Funktion sein.

Wie immer bedeutet dies nicht, dass Unternehmen den einen oder anderen Ansatz wählen müssten. Beide Konzepte – Data Mesh, vollständig domänenbasiert mit sich herausbildender Governance, ebenso wie Data Fabric mit seiner augmentierten aktiven Metadaten-Management-Lösung – können nebeneinander existieren. Es hängt von den konkreten Anforderungen des jeweiligen Unternehmens ab, die richtige Balance zwischen diesen beiden Architekturen zu finden.

Fazit

In dieser Blog-Serie habe ich mich auf das Metadaten-Management in Datenplattformen konzentriert. Ich habe gezeigt, warum das ursprüngliche, passive Metadaten-Management nicht zu den Anforderungen moderner Datenplattform-Architekturen passt und warum es durch autonome Prozesse aktiver Daten-Management-Strategien unterstützt oder sogar ersetzt werden muss. Anschliessend verglich ich die jeweilige Herangehensweisen an die Data Governance, für die das Metadaten-Management bei zwei prominenten Datenarchitekturen eine entscheidende Rolle spielt: Data Mesh und Data Fabric. Beide bieten vielversprechende Abhilfe für Probleme im Zusammenhang mit der ständig weiter wachsenden Komplexität von Datenplattformen.

Wir bei Mimacom würden uns sehr freuen, Sie bei der Identifizierung des richtigen Pfads für Ihre Datenplattform und deren Entwicklung in Ihrem Unternehmen unterstützen zu dürfen!

Glossar – Metadaten-Management

Datenabstammung: Eine Art der Betrachtung, wie Daten durch die gesamte Plattform fliessen. Diese soll Erkenntnisse in mehreren verschiedenen Dimensionen liefern: welche Systeme wann teilnehmen, wie die Daten innerhalb eines einzelnen Systems umgewandelt und verarbeitet werden und schliesslich wie die Daten mit Geschäftsprozessen verknüpft sind.

Datenherkunft: Ein wesentlicher Teil der Datenabstammung, der sich mit dem Ursprung von Daten befasst, d. h. der Schicht der Datenerfassung sowie mit Datenquellen.

Data Governance: Eine Reihe von Aktivitäten, zu denen die Beschreibung, Konstruktion, Implementierung und Durchsetzung von Kontrolle über Daten und Datenmanagementprozesse gehören. Sie verknüpft Daten mit Datenverantwortung bzw. Data Stewardship, ist eng verwandt mit der Datensicherheit und stützt sich in hohem Masse auf Metadaten.

Data Mesh: Ein Architekturansatz für Datenplattformen. Der natürliche nächste Schritt in der Entwicklung des Data Lake. Das Prinzip des Domain-Driven Designs macht sich verteilte Architekturen, Flexibilität und sinnvolle Projektunabhängigkeit zu eigen, während gleichzeitig die Zugänglichkeit und Verfügbarkeit der Daten erhalten bleibt.

Data Fabric: Ein Architekturansatz, der darauf abzielt, nahtlosen Zugriff auf Daten bereitzustellen – und das so, dass durch Nutzung autonomer Verfahren die erforderlichen regulatorische Bestimmungen erfüllt werden.

Datendemokratisierung: Ein Ansatz, Daten näher zu allen interessierten Parteien zu bringen. Die Bereitstellung von Tools und Diensten an alle, um Daten effizienter zu finden und zu nutzen. Dieser Trend kann Self-Service-Portale für die Entdeckbarkeit und Bereitstellung von Daten ebenso nutzen wie Marktplätze, die alle Arten von Metadaten nutzen, oder intelligente Dienste, die verschiedene Entscheidungsprozesse unterstützen.

Schema-on-write vs. Schema-on-read: Schema-on-write ist ein Verfahren zur Definition einer Datenstruktur vor dem Schreiben in die DB. Dies ist ein ursprünglicher Ansatz, der bei RDBs beliebt war. Schema-on-read ist demgegenüber ein agilerer Ansatz, bei dem das Schema erst während der Nutzung der Daten definiert wird. Schema-on-read beschleunigt den Prozess des Onboardings neuer Datenquellen.

Pawel Wasowicz

Pawel lebt in Bern und ist Lead Data Engineering in Digital Foundation. Er hilft unseren Kunden, durch optimale Nutzung der neuesten Trends, bewährter Technologien und seiner jahrelangen Erfahrung auf diesem Gebiet das meiste aus Ihren Daten zu machen.